고정 헤더 영역

상세 컨텐츠

본문 제목

쉽게 ppt로 정리한 밑바닥 딥러닝1 day 4_2 옵티마이저, sgd, adagrad, momentum, rmsprop, adam, xavier, he

본문

keywords :

옵티마이저 optimizer softmax with loss cross entropy optimizer 최적화 SGD stochastic gradient descent 비등방성 anisotropy 모멘텀 momentum

adagrad learning rate decay 학습률 감소 에타 eta 학습률 RMSProp exponentially weighted moving average 지수 가중 이동

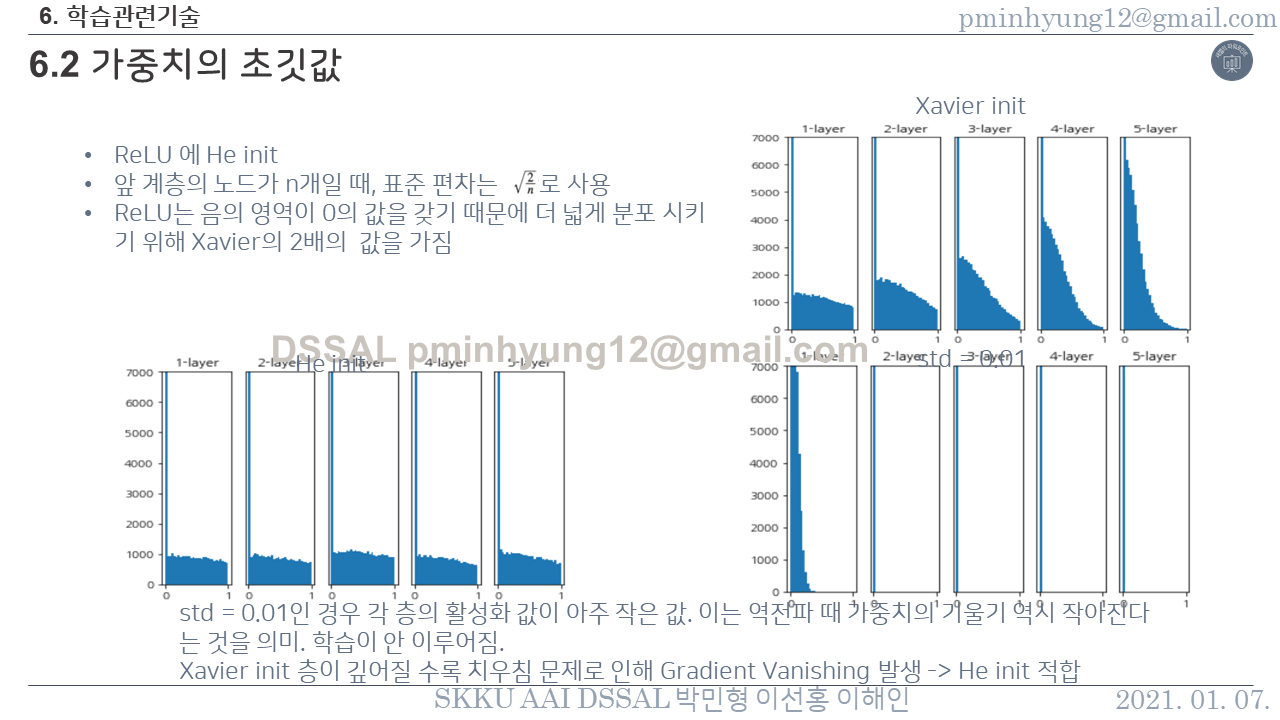

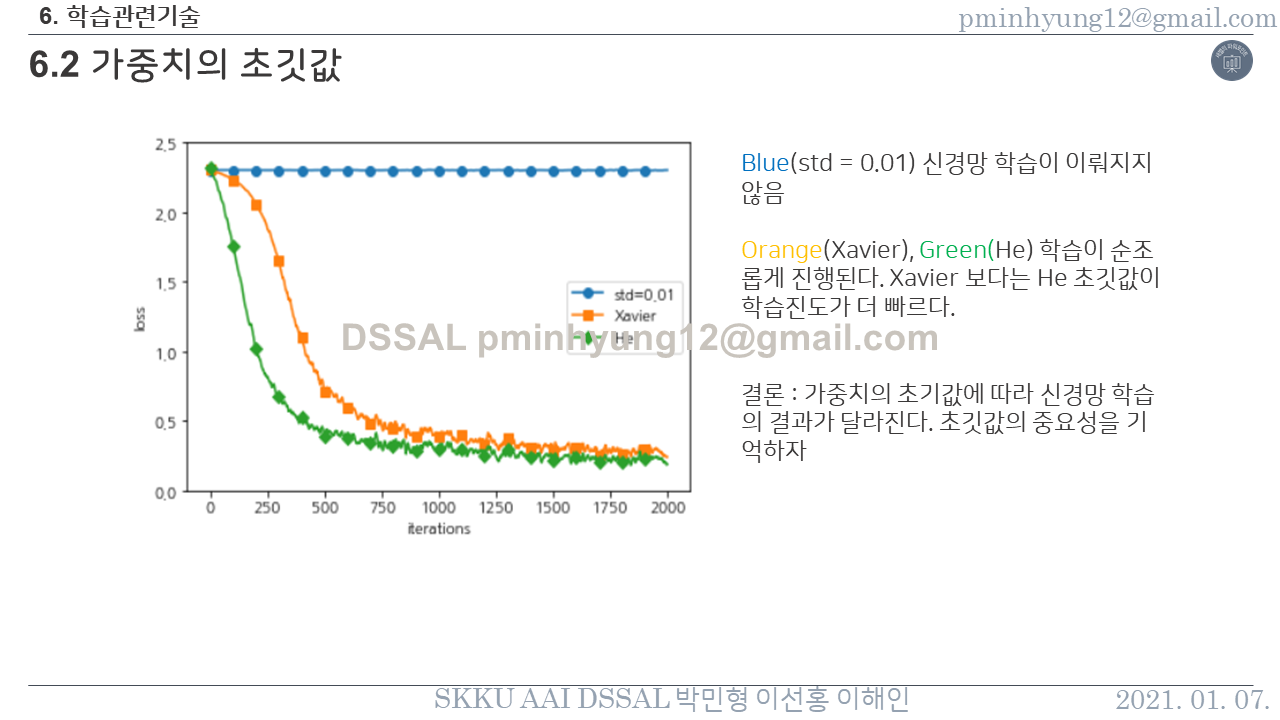

adam weight decay 가중치 감소 sigmoid 시그모이드 Xavier 자비에 초기화 He 헤 relu 함수

본 게시물은 "밑바닥부터 시작하는 딥러닝1"을 공부한 것을 바탕으로 정리한 자료입니다.

<Reference >

"밑바닥부터 시작하는 딥러닝1"

댓글 영역